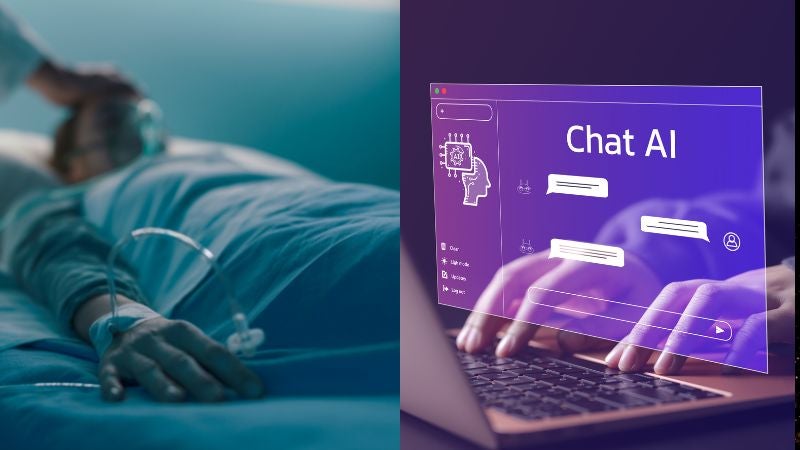

Redacción. Un hombre de 60 años fue hospitalizado luego de consultar a ChatGPT cómo eliminar el cloruro de sodio de su dieta. Este caso ejemplifica los riesgos que pueden surgir al confiar en recomendaciones médicas provenientes de inteligencia artificial sin supervisión profesional.

A medida que la interacción con chatbots y sistemas de IA aumenta, crecen también las historias que evidencian cómo una conversación con estas herramientas puede tener consecuencias inesperadas, incluso peligrosas para la salud física y mental.

El peligro de automedicarse con IA

El paciente, sin antecedentes médicos o psiquiátricos relevantes, presentó síntomas graves tras reemplazar la sal común por bromuro de sodio, sustancia que adquirió luego de consultar con ChatGPT.

En su hospitalización sufrió bromismo o intoxicación por bromuro, condición que aunque era común en la década de 1990, hoy es poco frecuente.

Durante las primeras 24 horas en el hospital, el hombre mostró paranoia y alucinaciones auditivas y visuales; estaba muy sediento, pero desconfiaba del agua que le ofrecían. Lo trataron con líquidos y electrolitos, y posteriormente lo ingresaron en una unidad psiquiátrica. A medida que mejoraba, reconoció síntomas como acné y angiomas en cereza, signos claros de bromismo.

El paciente llevaba tres meses sustituyendo el cloruro de sodio por bromuro de sodio tras leer sobre los efectos negativos de la sal. Su decisión estuvo inspirada en conocimientos previos de nutrición y en la información que obtuvo, erróneamente, a través de ChatGPT, donde leyó que el cloruro podía reemplazarse por bromuro, posiblemente con fines de limpieza.

Después de tres semanas hospitalizado, pudo recuperarse y recibir el alta.

Atención

Los autores del informe, publicado en la revista del Colegio Estadounidense de Médicos, advierten que ChatGPT y otros sistemas de inteligencia artificial pueden generar información científica imprecisa, carecer de la capacidad crítica necesaria y facilitar la difusión de datos erróneos.

OpenAI, desarrollador de ChatGPT, reconoce en sus condiciones de uso que los resultados del chatbot “pueden no ser siempre exactos” y recomienda no utilizar sus respuestas como sustituto del consejo profesional ni para diagnósticos o tratamientos médicos.

Este caso resalta la importancia de consultar siempre a profesionales de la salud antes de hacer cambios significativos en la alimentación o el tratamiento médico.